Analizamos cómo la inteligencia artificial está transformando la defensa, desde las implicaciones éticas hasta los robots autónomos en el campo de batalla.

Debate sobre IA en Defensa: Perspectivas y Desafíos

En una reciente entrevista con CNN, el expresidente Barack Obama destacó las revolucionarias contribuciones de la inteligencia artificial (IA) a la sociedad, al tiempo que resaltó sus limitaciones inherentes. Afirmó que, a pesar de los avances, las máquinas carecen de capacidad para replicar emociones humanas como la alegría. Esta declaración pone de relieve los desafíos éticos y filosóficos que enfrenta la IA, especialmente en contextos militares y de defensa.

Obama enfatizó la dualidad de la IA: su potencial para ofrecer innovaciones disruptivas y, al mismo tiempo, introducir complejidades sin precedentes. Reconoció los esfuerzos del Pentágono y entidades como el Laboratorio de Investigación de las Fuerzas Aéreas en la integración de la IA para comprender fenómenos subjetivos humanos. Sin embargo, subrayó que ciertos aspectos de la cognición y la emoción humanas permanecen fuera del alcance de los algoritmos actuales.

El expresidente subrayó la importancia de un enfoque combinado en el desarrollo de armamento, promoviendo la cooperación entre sistemas tripulados y no tripulados. Esta perspectiva sugiere un equilibrio entre la intervención humana y la autonomía de la IA en situaciones de combate, manteniendo así el control humano sobre las decisiones críticas.

El Laboratorio de Investigación del Ejército y el Futuro de la IA en Defensa

Investigadores del Laboratorio de Investigación del Ejército han enfatizado que nos encontramos solo en el inicio de lo que la IA puede lograr en el ámbito de la defensa. El Pentágono está explorando activamente las aplicaciones de la IA en contextos no letales, buscando combinar la capacidad de toma de decisiones humanas con la velocidad y precisión de la computación de IA. Este enfoque ya está generando avances significativos, como la reducción del ciclo sensor-tirador en proyectos como el Proyecto Convergencia del Ejército.

La fiabilidad de los análisis generados por IA es un área de interés crítico, con esfuerzos dirigidos a mejorar el aprendizaje automático y el análisis en tiempo real. Según la General de División Heather Pringle, ex comandante del Laboratorio de Investigación de las Fuerzas Aéreas, el desafío reside en evolucionar la IA más allá de las bases de datos para abordar conceptos y relaciones más complejas, similares a las capacidades humanas.

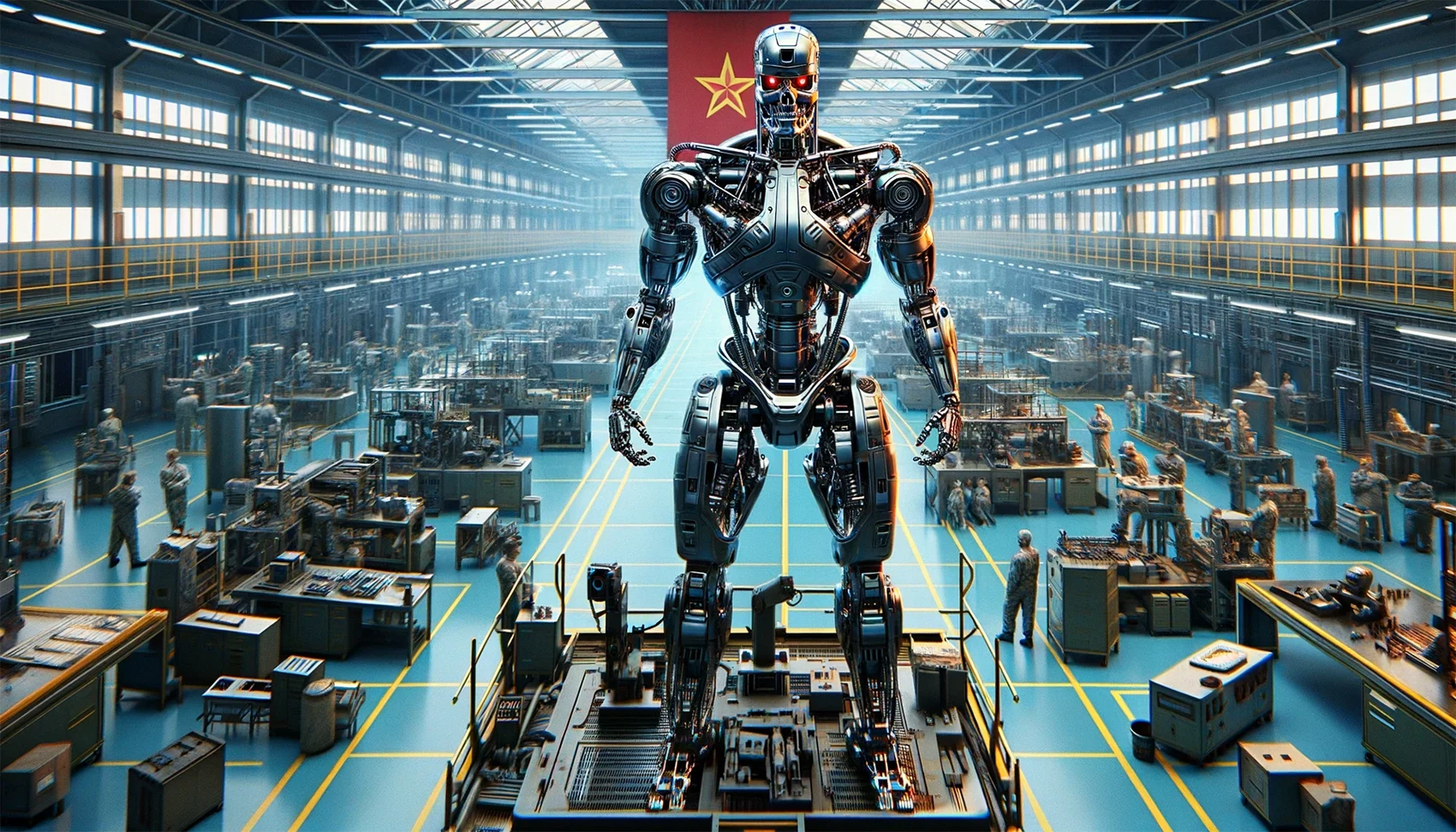

En escenarios donde amenazas como enjambres de drones o misiles hipersónicos requieren respuestas inmediatas, la IA podría desempeñar un papel crucial. Los tiempos de reacción humanos pueden ser insuficientes ante estos ataques de alta velocidad, lo que plantea la necesidad de sistemas autónomos capaces de tomar decisiones rápidas y precisas.

Robots Armados y Sistemas Autónomos: ¿El Futuro de la Guerra?

La pregunta sobre cuándo surgirán robots armados tipo “TERMINATOR”, capaces de operar de forma autónoma, es pertinente en el actual panorama tecnológico. Si bien la tecnología para robots armados teleoperados ya existe, la doctrina del Pentágono sigue exigiendo la presencia humana en la toma de decisiones relativas al uso de la fuerza letal. Sin embargo, la posibilidad de sistemas de IA que tomen decisiones autónomas en contextos de fuerza no letal está siendo explorada activamente.

La cuestión central es si los sistemas de IA deberían tener la capacidad de discernir entre fuerza letal y no letal, y si podrían implementarse en tareas defensivas, como la intercepción de drones o la neutralización de amenazas enemigas. La IA en el campo de batalla no solo plantea preguntas técnicas, sino también profundas interrogantes éticas y filosóficas sobre la naturaleza y el control de la guerra en la era de la Inteligencia Artificial.

Debate en Torno a la Autonomía de la IA en los Sistemas de Defensa

El coronel Marc E. Pelini, jefe de la división de capacidades y requisitos de la Oficina Conjunta de Sistemas Aéreos no Tripulados, expresó en una teleconferencia en 2021, según un informe del Pentágono, que la política actual exige la intervención humana en el ciclo de decisión de los sistemas de armas. Esta postura refleja la cautela actual del Departamento de Defensa en relación con la autonomía total de las máquinas en la toma de decisiones letales.

La creciente velocidad y precisión de la IA en la interpretación de datos de sensores y en la identificación de amenazas plantean la pregunta de si debería permitirse a los sistemas autónomos actuar en milisegundos para contrarrestar amenazas. Pelini señaló la relevancia de esta cuestión, especialmente en escenarios donde las amenazas emergentes, como los enjambres de drones, requieren respuestas rápidas y precisas.

La capacidad actual de la IA para analizar variables como la forma, velocidad, señales térmicas y acústicas de objetos, junto con el análisis del entorno y datos históricos, abre la posibilidad de que estas máquinas puedan determinar la respuesta más adecuada en un escenario de amenaza. Sin embargo, persisten dudas sobre si estas decisiones deberían tomarse fuera del ciclo de control humano.

Implicaciones Éticas y Tecnológicas de Sistemas Autónomos en la Defensa

La posibilidad de emplear armas autónomas para respuestas rápidas en el campo de batalla es un tema que está siendo evaluado tanto desde un punto de vista conceptual como tecnológico. Expertos y futuristas consideran la implementación de sistemas “fuera del bucle” que puedan operar independientemente en ciertos contextos, especialmente en situaciones no letales. Aunque la tecnología necesaria para estos sistemas autónomos existe en cierta medida, esto no resuelve las cuestiones éticas, tácticas y doctrinales que acompañan a tal autonomía.

Ross Rustici, ex alto cargo del Departamento de Defensa y experto en IA y ciberseguridad, destaca la complejidad y los matices de esta cuestión. Señala que, aunque tecnológicamente factible, la confianza en las máquinas para tomar decisiones autónomas sigue siendo un tema debatido. Rustici advierte sobre la necesidad de cautela, especialmente cuando los sistemas defensivos tienen capacidad letal, ya que cualquier fallo podría tener consecuencias mortales.

En el caso de contramedidas no cinéticas, Rustici ve más viable el uso de IA y automatización, pero mantiene reservas sobre la delegación completa de la fuerza letal a las máquinas. Resalta la importancia de una gestión de errores integrada en la que los humanos puedan supervisar y corregir posibles fallos o datos erróneos. Esta visión apoya la idea de mantener una interfaz hombre-máquina donde el escepticismo humano sirva como un cheque esencial sobre la tecnología.

La IA influye en la defensa al transformar la toma de decisiones, permitiendo respuestas rápidas a amenazas. Sin embargo, el expresidente Obama destaca limitaciones éticas, como la incapacidad de las máquinas para replicar emociones humanas, subrayando la importancia de un enfoque equilibrado entre intervención humana y autonomía.

El Laboratorio de Investigación del Ejército se enfoca en avanzar en la aplicación de la IA en defensa. Se exploran aplicaciones no letales, como el Proyecto Convergencia, buscando mejorar la fiabilidad de análisis y abordar conceptos complejos más allá de las bases de datos.

La IA aborda amenazas como enjambres de drones y misiles hipersónicos al proporcionar respuestas inmediatas. La velocidad y precisión de la IA son cruciales ante ataques de alta velocidad, mejorando la capacidad de toma de decisiones en situaciones críticas.

La posibilidad de ver robots armados operando de forma autónoma en el campo de batalla es un tema actual. Aunque la tecnología existe para robots teleoperados, la doctrina del Pentágono requiere presencia humana en decisiones de fuerza letal. La exploración de sistemas autónomos en contextos no letales está en curso.

El debate sobre la autonomía de la IA en sistemas de defensa refleja la postura actual del Departamento de Defensa, que exige intervención humana en el ciclo de decisión. La velocidad y precisión de la IA plantean preguntas sobre permitir a sistemas autónomos actuar rápidamente, generando preocupaciones éticas y tácticas en decisiones letales. La gestión de errores y la supervisión humana son consideradas esenciales para mantener la confianza en la tecnología.

Las implicaciones éticas de sistemas autónomos en defensa incluyen preocupaciones sobre la toma de decisiones letales sin intervención humana directa, generando interrogantes sobre responsabilidad y derechos humanos. Tecnológicamente, la rapidez de la inteligencia artificial plantea desafíos en la interpretación precisa de situaciones complejas. La gestión de errores y la supervisión humana son esenciales para evitar consecuencias no deseadas. Además, surgen cuestiones legales y de transparencia en la implementación de esta tecnología en contextos militares.